La transformée de Fourier discrète est une transformation qui découle de la transformée de Fourier et est, comme son nom l’indique, adaptée pour des signaux discrets. Dans cette première partie je vous propose de découvrir comment construire la transformée de Fourier discrète puis comprendre pourquoi la transformée de Fourier rapide est utile.

- La transformée de Fourier

- De la transformée de Fourier à la transformée de Fourier discrète

- Calculer la transformée de Fourier discrète

- Pourquoi un algorithme de transformée de Fourier rapide ?

La transformée de Fourier

Ce tutoriel n’a pas vocation à présenter la transformée de Fourier. Cependant, il existe plusieurs définitions de la transformée de Fourier et même au sein d’un unique domaine, il arrive que l’on en utilise plusieurs. Nous utiliserons la suivante : pour une fonction , sa transformée de Fourier est définie par:

De la transformée de Fourier à la transformée de Fourier discrète

Telle que défini dans la section précédente, la transformée de Fourier d’un signal est une fonction continue de la variable . Or, pour représenter un signal quelconque, nous ne pouvons utiliser qu’un nombre fini de valeurs. Pour cela on procède en quatre étapes :

- On échantillonne (ou discrétise) le signal à analyser. Cela signifie qu’au lieu de travailler sur la fonction qui associe la valeur du signal en fonction de la variable , on va travailler sur une suite discrète de valeurs du signal. Dans le cas de la FFT, on échantillonne avec un pas constant. Par exemple si on regarde un signal temporel comme la valeur d’une tension lue sur un voltmètre, on pourrait enregistrer la valeur à chaque tic d’une montre.

- On fenêtre le signal discrétisé. Cela signifie que l’on garde uniquement un nombre fini de points du signal.

- On échantillonne la transformée de Fourier du signal pour obtenir la transformée de Fourier discrète.

- On fenêtre la transformée de Fourier discrète pour le stockage.

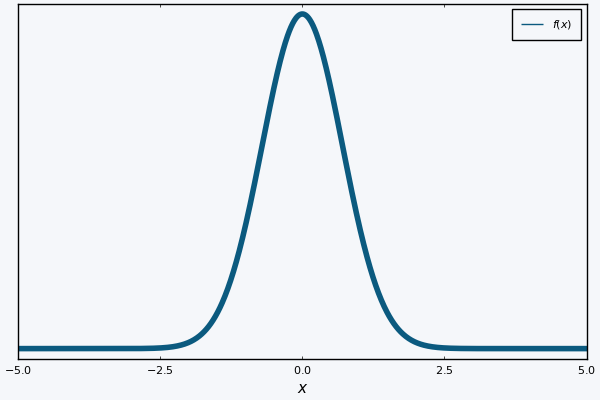

Je vous propose de raisonner sur un signal jouet qui aura la forme d’une Gaussienne. Cela rend le raisonnement un peu plus simple car la transformée de Fourier d’une Gaussienne réelle est elle aussi une gaussienne réelle,1 ce qui simplifie les représentations graphiques.

Plus formellement, on a:

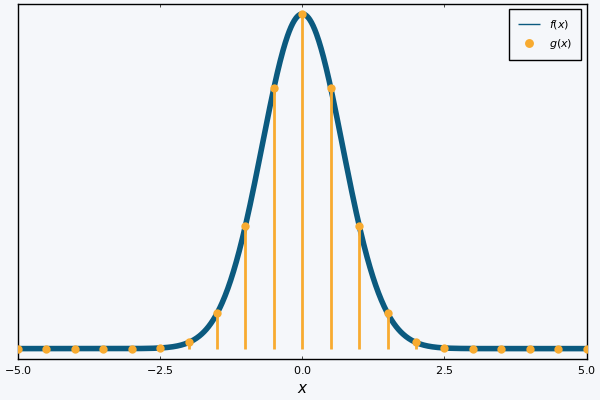

Intéressons-nous tout d’abord à l’échantillonnage. Mathématiquement, on peut représenter le processus par la multiplication du signal par un peigne de Dirac de péridode , . Le peigne de Dirac est défini ainsi :

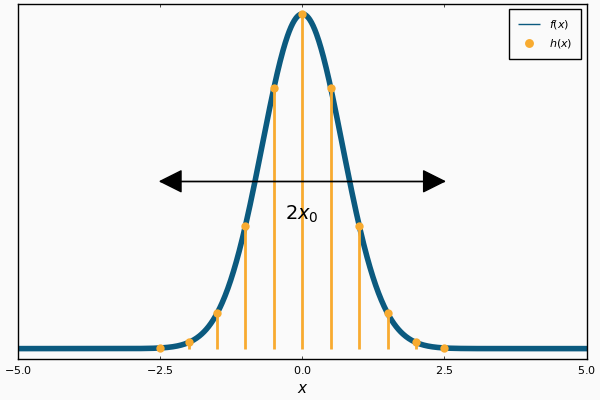

Avec la distribution de Dirac. Voici le graphe que l’on peut obtenir si l’on représente et ensemble :

La transformée de Fourier de la nouvelle fonction s’écrit2 :

Si on pose le signal échantillonné et la fréquence d’échantillonnage, on a:

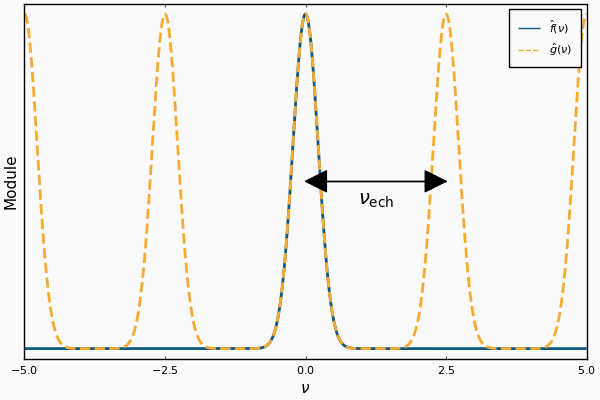

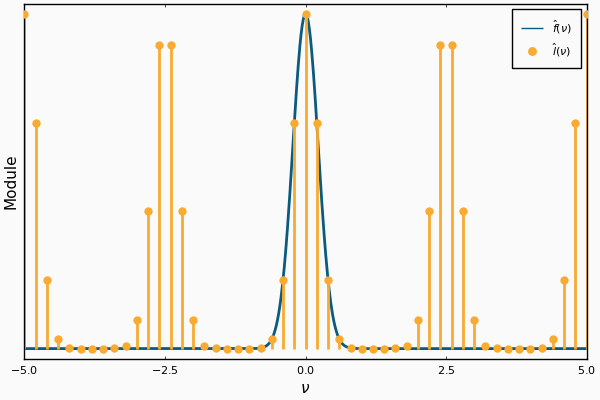

Si on trace la transformée de Fourier du signal de départ et celle du signal échantillonné , on obtient le graphe suivant :

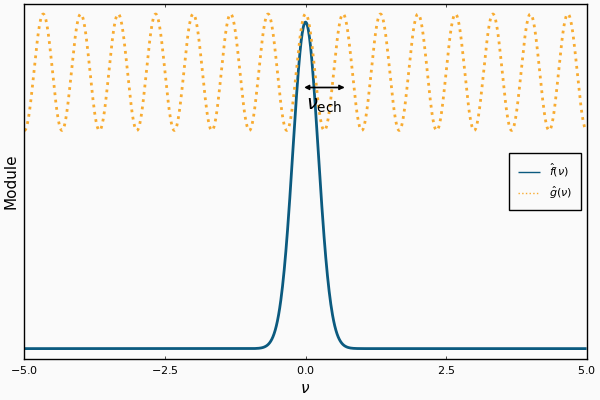

On remarque que l’échantillonnage du signal a amené à la périodisation de sa transformée de Fourier. Cela mène à une propriété importante en traitement du signal : le critère de Nyquist-Shanon, et une de ses conséquences, le repliement de spectre, ou aliasing. Je vous laisse consulter l’article Wikipédia à ce propos si cela vous intéresse, mais on peut se faire une rapide idée de ce qu’il se passe si l’on trace le graphe précédent avec un échantillonnage trop large : les cloches de la transformée du signal échantillonné se superposent.

On peut ensuite regarder le processus de fenêtrage. Il existe plusieurs méthodes qui ont chacune leurs avantages, mais nous nous intéresserons ici uniquement à la fenêtre rectangulaire. Le principe est simple : on ne regarde que les valeurs de que pour compris entre et . Cela signifie que l’on multiplie la fonction par une fonction porte qui vérifie :

Graphiquement, voici comment on pourrait représenter et ensemble.

Concrètement, c’est équivalent à limiter la somme du peigne de Dirac à un nombre fini de termes. On peut alors écrire la transformée de Fourier de :

Le choix du fenêtrage n’est absolument pas anodin, et peut mener à des problèmes innatendus si on l’ignore. Là encore je vous conseille de consulter l’article Wikipédia associé au besoin.

Nous pouvons maintenant passer à la dernière étape : l’échantillonnage de la transformée de Fourier. En effet, on ne peut stocker qu’un nombre fini de valeurs sur notre ordinateur or, telle que définit, la fonction est continue. On sait déjà qu’elle est périodique, de période , on peut donc ne stocker que les valeurs entre et . Il reste encore à l’échantillonner, et en particulier à trouver le pas d’échantillonnage adéquat. Il est clair que l’on souhaite que l’échantillonnage soit le plus "fin" possible, pour ne manque aucun détail de la transformée de Fourier ! Pour cela on peut s’inspirer de ce qu’il s’est passé lorsque l’on a échantillonné : sa transformée de Fourier est devenue périodique, de période . Or la transformée de Fourier inverse (l’opération qui permet de retrouver le signal à partir de sa transformée de Fourier) possède des propriétés similaires à la transformée de Fourier. Cela signifie que si on échantillonne avec un pas d’échantillonnage , alors sa transformée de Fourier inverse devient périodique de période . Cela donne une limite basse sur les valeurs que peut prendre ! En effet, si la transformée inverse a une période inférieure à la largeur de a fenêtre (), alors le signal reconstruit pris entre et ne correspondra pas au signal initial !

On choisit donc pour discrétiser . On utilise le même processus de multiplication par un peigne de Dirac pour discrétiser. De cette manière on obtient la transformée de Fourier d’une nouvelle fonction :

Cette notation est un peu compliquée, et on peut s’intéresser plutôt à :

Pour obtenir la dernière ligne, j’ai ré-indicé de manière à commencer à 0, en notant le nombre d’échantillons. J’ai ensuite supposé que la taille de la fenêtre correspondait à un nombre entier d’échantillons c’est-à-dire que , ce qui se réécrit . Cette expression est la transformée de Fourier discrète du signal.

On voit que la fréquence d’échantillonnage n’entre pas en compte dans cette équation, et il y a de nombreuses applications où on oublie purement et simplement l’existence de cette fréquence.

Il reste un dernier point à éclaircir: cette transformée discrète est définie pour une infinité (discrète) de valeurs de . Comment la stocker sur notre ordinateur ?

Ce problème est résolu assez simplement par un fenêtrage de la transformée de Fourier discrète. Puisque la transformée a été périodisée par l’échantillonnage du signal de départ, il suffit de stocker une période de la transformée pour stocker l’intégralité de l’information contenue dans cette dernière. Le choix qui est généralement fait est de garder tous les points entre O et . Cela permet de n’utiliser que des positifs, et on peut reconstruire facilement le graphe de la transformée au besoin en inversant la première et la seconde moitiée de la transformée calculée. En pratique (pour l’implémentation), la transformée de Fourier discrète est donc donnée par :

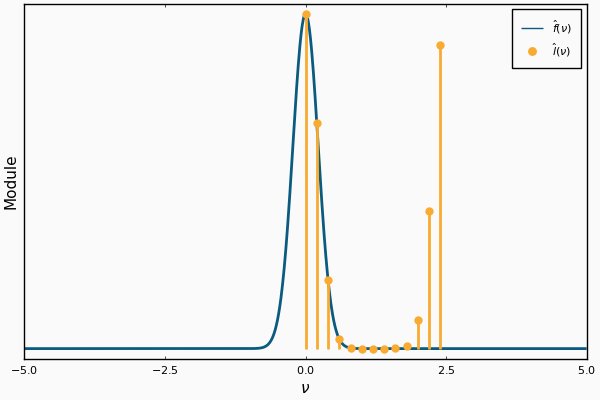

Pour conclure sur notre fonction d’exemple, on obtient le graphe suivant :

Calculer la transformée de Fourier discrète

Nous avons donc à notre disposition l’expression de la transformée de Fourier discrète d’un signal :

Cette expression est celle d’un produit matriciel qui ressemblerait à ceci:

avec

Les connaisseurs remarqueront qu’il s’agit ici d’une matrice de Vandermonde sur les racines de l’unité.

On peut donc implémenter relativement simplement ce calcul !

function naive_dft(x)

N = length(x)

k = reshape(0:(N-1), 1, :)

n = 0:(N-1)

M = @. exp(-2im * π * k * n / N)

M * x

end

La macro @. ligne 5 permet de vectoriser le calcul de l’expression qu’elle englobe (exp(-2im * π * k * n / N)). En effet la fonction exp et les opérateurs de division et multiplication sont définis pour des scalaires. Cette macro permet d’informer Julia qu’il doit appliquer les opérations scalaires terme à terme.

Et pour vérifier qu’il donne effectivement le bon résultat, il suffit de le comparer avec une implémentation de référence :

using FFTW

let

a = rand(1024)

b = fft(a)

c = naive_dft(a)

b ≈ c

end

Le dernier bloc s’évalue à true, ce qui confirme que nous ne sommes pas totalement à côté de la plaque !

J’utilise l’opérateur ≈ pour comparer plutôt que == afin d’autoriser des petites différences, notamment à cause des erreurs d’arrondies sur les flottants.

Cependant, ce code est-il efficace ? On peut le vérifier en comparant l’empreinte mémoire et la vitesse d’exécution.

using BenchmarkTools

let

@benchmark fft(a) setup=(a = rand(1024))

end

BenchmarkTools.Trial: 10000 samples with 1 evaluation.

Range (min … max): 26.134 μs … 13.261 ms ┊ GC (min … max): 0.00% … 56.15%

Time (median): 32.502 μs ┊ GC (median): 0.00%

Time (mean ± σ): 37.547 μs ± 184.201 μs ┊ GC (mean ± σ): 4.03% ± 0.82%

▆▆▄▅▅▇▇▆██▅▅▆▅▃▁ ▁▁▁▁▂▂▂▃▂▃▂▂▂▂▁▁ ▁▁ ▃

▇▆████████████████████████▇█████████████████████▇████▆▇▅▆▆▇▇ █

26.1 μs Histogram: log(frequency) by time 61.5 μs <

Memory estimate: 34.19 KiB, allocs estimate: 34.

let

@benchmark naive_dft(a) setup=(a = rand(1024))

end

BenchmarkTools.Trial: 52 samples with 1 evaluation.

Range (min … max): 54.047 ms … 131.510 ms ┊ GC (min … max): 0.00% … 0.00%

Time (median): 96.858 ms ┊ GC (median): 0.00%

Time (mean ± σ): 96.784 ms ± 10.861 ms ┊ GC (mean ± σ): 0.92% ± 2.47%

▁ █▂

▃▁▁▃▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▃▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▁▃▃▁▇█▃██▃▃▇▃▁▃▄▃▄▁▃▄ ▁

54 ms Histogram: frequency by time 109 ms <

Memory estimate: 16.03 MiB, allocs estimate: 4.

Comme vous avez pu le constater le temps d’exécution maximal de l’implémentation de référence est plus élevé de deux ordres de grandeur que les temps d’exécution moyen et médian. On doit cela à la compilation Just in time (JIT) de Julia. Si nous étions en train d’écrire une vraie bibliothèque Julia on pourrait envisager d’optimiser notre code pour qu’il compile rapidement. Nous nous contenterons d’ignorer le temps d’exécution maximum dans ce tutoriel, qui correspond uniquement au temps de compilation pour la première exécution du code. Je vous renvoie à la documentation de BenchmarkTools.jl pour plus d’informations.

Notre implémentation est donc vraiment lente (environ 10000 fois plus) et possède une empreinte mémoire très élevée (environ 500 fois) par comparaison avec l’implémentation de référence ! Pour améliorer cela, nous allons implémenter la transformée de Fourier rapide.

Pourquoi un algorithme de transformée de Fourier rapide ?

Avant de replonger les mains dans le cambouis, posons-nous d’abord la question : est-il bien nécessaire de chercher à améliorer cet algorithme ?

Avant de répondre directement, intéressons-nous à quelques applications de la transformée de Fourier et de la transformée de Fourier discrète.

La transformée de Fourier a d’abord une foultitude d’applications théoriques, que ce soit pour résoudre des équations différentielles, en traitement du signal ou en physique quantique. Elle possède également des applications pratiques en optique et en spectroscopie.

La transformée de Fourier discrète a également de nombreuses applications, en analyse des signaux, pour la compression de données, la multiplication de polynômes ou le calcul de produits de convolutions.

Notre implémentation naïve de la transformée de Fourier discrète a une complexité en temps et en mémoire en avec la taille de l’échantillon d’entrée, cela est dû au stockage de la matrice et au temps de calcul du produit matriciel. Concrètement, si on souhaitait analyser un signal sonore de 3 secondes échantilloné à 44kHz avec des données stockées sur avec des flottants simple précision (4 octets), il faudrait donc environ octets de mémoire (un nombre complexe est stocké sur 2 flottants). On peut aussi estimer le temps nécessaire à faire ce calcul. Le temps médian pour 1024 points était de 38.367 ms. Pour notre signal de 3 secondes, il faudrait environ millisecondes, soit plus de 10 minutes !

On comprend aisément l’intérêt de réduire la complexité du calcul. En particulier l’algorithme de la transformée de Fourier rapide (utilisé par l’implémentation de référence) possède une complexité en . D’après notre benchmark, l’algorithme traite une entrée de 1024 points en 23.785µs. Il devrait donc traiter le signal sonore en environ micro-secondes, soit environ 120000 fois plus rapidement que notre algorithme. On peut vraiment dire que le fast de Fast Fourier Transform n’est pas volé !

Nous avons vu comment la transformée de Fourier discrète était construite, puis nous avons tenté de manière naïve de l’implémenter. Bien que cette implémentation soit relativement simple à mettre en œuvre (surtout avec un langage tel que Julia qui facilite les manipulations de matrices), nous avons également vu ses limites en termes de temps d’exécution et d’empreinte mémoire.

Il est temps de passer à la FFT proprement dite !